Yann LeCun:来自法国的代码骑士

2018年,有“计算机界的诺贝尔奖”之称的图灵奖,颁发给Yann LeCun、Geoffrey Hinton、Yoshua Bengio,以表彰三位在深度学习领域的卓越贡献。

2020年,Yann LeCun、Yoshua Bengio入选有“人工智能名人堂”之称的AAAI Fellow,而Geoffrey Hinton则在1990年就入选,三巨头再次重聚。

本文介绍三巨头之一、CNN之父Yann LeCun。

早年

LeCun于1960年7月8日出生于法国巴黎西北边的一个小镇上,全名Yann André Le Cun。后来考虑到主要在美国、加拿大发展,为了避免别人将

last name的一部分Le误以为middle name,就将名字改为Yann LeCun。此外,LeCun的中文译名原为扬·勒丘恩,早年华人AI圈一直亲切地叫

他“杨乐康”。LeCun知道后,索性给自己起了个中文名,叫杨立昆。虽然不符合中英文姓、名的对应关系,但确实很朗朗上口。

LeCun的父亲是航空机械工程师,在他的影响下,LeCun从小对科学和工程非常感兴趣。他在17岁时拥有了一台单板机(单板微型计算机,如今的树莓派是它继续发展的产物),于是,他自己编程,在一块只能显示6个数字的屏幕上打造自己的管乐合成器。

LeCun本科就读于巴黎高等电子与电气工程师学校,并在1983年取得电机工程师学位。在他本科期间,读到了出版于1969年、在人工智能历史上赫赫有名的《感知机:计算几何学概论》。这本书的作者马文·明斯基(Marvin L. Minsky),在读博期间提出“神经网络”的概念,被誉为“人工智能之父”,而感知机就是单层的神经网络;另一位作者西摩尔·派普特(Seymour Papert),是机器学习的倡导者和教育、认知科学家。

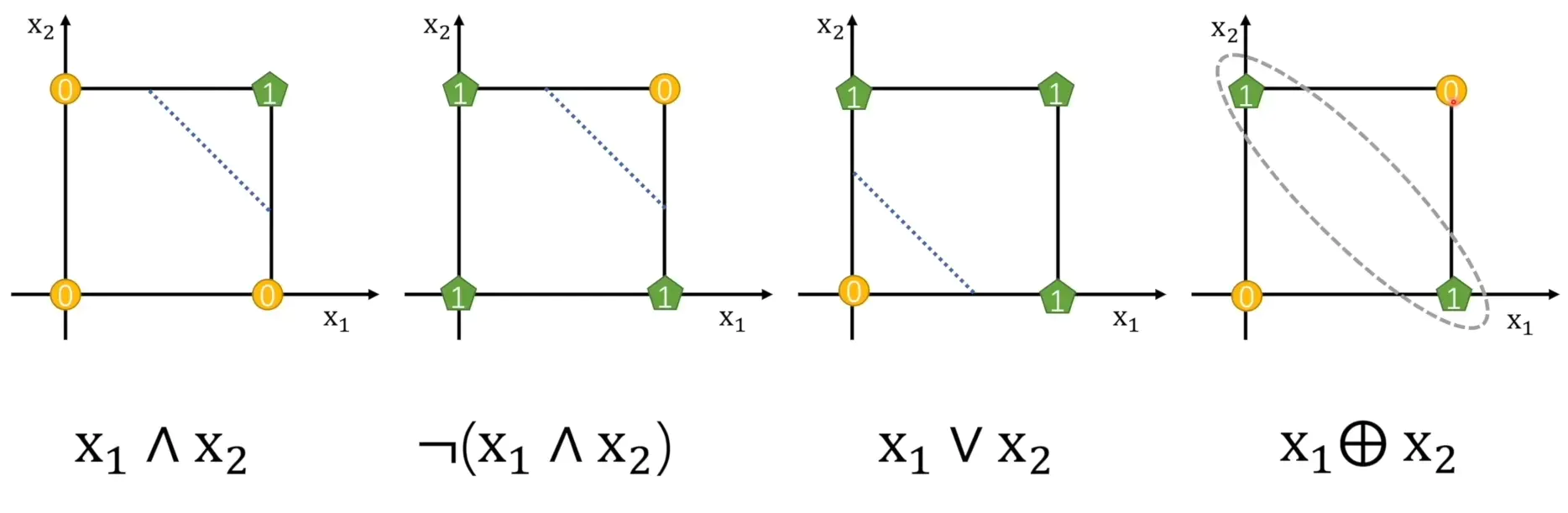

在这本书中,他们总结了感知机的发展,也毫不留情地指出了它的缺陷——无法处理线性不可分问题,例如异或(XOR),史称“The XOR Affair”。尽管并非作者本意,这本书在当年还是让方兴未艾的神经网络陷入长达近二十年的寒冬。也有人声称,感知机的发明者弗兰克·罗森布拉特(Frank Rosenblatt),就是因此自杀的。他在1971年生日那天划船淹死,年仅四十三岁。

尽管如此,LeCun还是被神经网络吸引,他在各大学的图书馆穿梭,寻找一切有关的资料。他想打造“可学习的机器”,也希望神经网络在AI领域复兴。顺理成章地,LeCun到巴黎第六大学(又称皮埃尔和玛丽·居里大学,2018年与巴黎第四大学合并为索邦大学)读了计算机科学的博士。

求学

在读博期间,LeCun将多层神经网络(MLP)和反向传播(BP)的算法结合,解决了感知机线性不可分的问题,但运行效率上有些问题。

后来,他与三巨头的另外一位杰弗里·辛顿(Geoffrey Hinton)结识,而后者也在研究反向传播算法。二人一拍即合,共同完成了这项神经网络的奠基性工作,各自发表了一篇相关论文。在1970s-1980s,也有其他组独立做出类似成果,这都让学界重拾对神经网络的信心,漫长的寒冬终于过去。

1987年,LeCun博士毕业,27岁的他远赴加拿大多伦多大学,在Hinton门下做博士后。在冬天,蒙特利尔一场学术会议中,LeCun发现一个博士生不时抛出有趣的问题,会下两人相谈甚欢,这就是三巨头的最后一位——约书亚·本吉奥(Yoshua Bengio)。可以看到,三巨头都活跃在加拿大,被业内戏称为“加拿大黑手党”。

职业

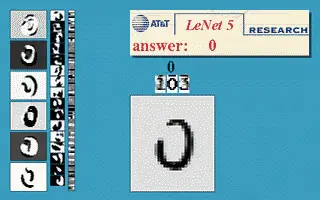

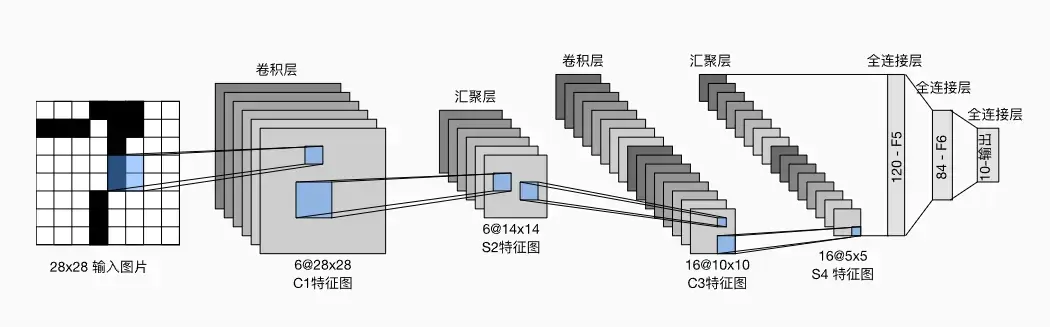

博后出站的LeCun来到美国电信巨头AT&T下属的AT&T贝尔实验室,这个实验室曾诞生过晶体管、信息论、UNIX系统、C语言,可以说是码农圣地。1993年,LeCun使用基于反向传播算法训练的卷积神经网络(CNN)LeNet,出色地完成了手写数字识别的任务,并成功完成了商业化,相关论文于1998年成文发表。LeCun也顺便整理了手写数字的数据集MINIST,成为机器学习历史上最经典的数据集之一,被Hinton称为“机器学习界的果蝇”。

LeNet具有划时代的意义,它第一次证明了CNN的实用性和商业价值,也奠定了神经网络最基础的功能分层。LeCun此时不到40岁,风华正茂,可以想见有无数迷人的想法在他脑海盘旋。手写数字被攻克了,那么可以识别图片中的物体吗(这项任务根据其区分粒度,如今被称为图像分类、图像语义分割等)?可惜的是,LeCun遇到了历史的天花板:越复杂的任务,就需要越多的隐藏层和参数,已经超出当时计算机算力的极限。

与此同时,AT&T公司进行部门调整,原来的实验室一分为二,资金开始短缺,相关研究计划被迫搁置。这些调整据说与美国《反垄断法》有关,但可以确定的是,贝尔实验室从此每况愈下,靠出售专利惨淡经营。于是长达六年的时间里,LeCun没有再碰神经网络,而是开发了新的图片压缩算法。该算法能提取图片中相似的部分,在重复出现时只记录位置信息,相比传统的jpg和pdf空间占用可减少五倍以上。算法名为DjVu,取自法语déja vu,意为似曾相识。

2002年,LeCun离开AT&T实验室,在普林斯顿停留了一年半,最后定居在纽约大学。在那里,LeCun成立了数据科学中心,研究基于能量的深度学习、无监督学习。

2013年,LeCun被Facebook聘请为新成立的AI部门的主任,此后诞生了行业内顶级的AI实验室之一FAIR(Facebook AI Research)。

同样在2013年,LeCun联合Bengio创立ICLR(International Conference on Learning Representations),已经成为深度学习顶会的“无冕之王”。深度学习有别于传统机器学习的特点,就是可以学到数据合适的表示(representation),这也是名字的来源。

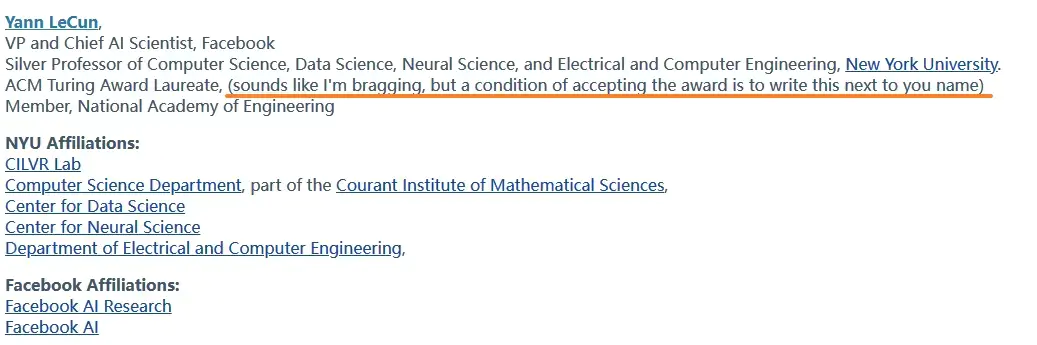

2018年,LeCun与Benjio、Hinton被授予图灵奖,从此“深度学习三巨头”的名号广为人知。有趣的是,LeCun在个人网站介绍该奖项时顺便吐槽了一波。

推特

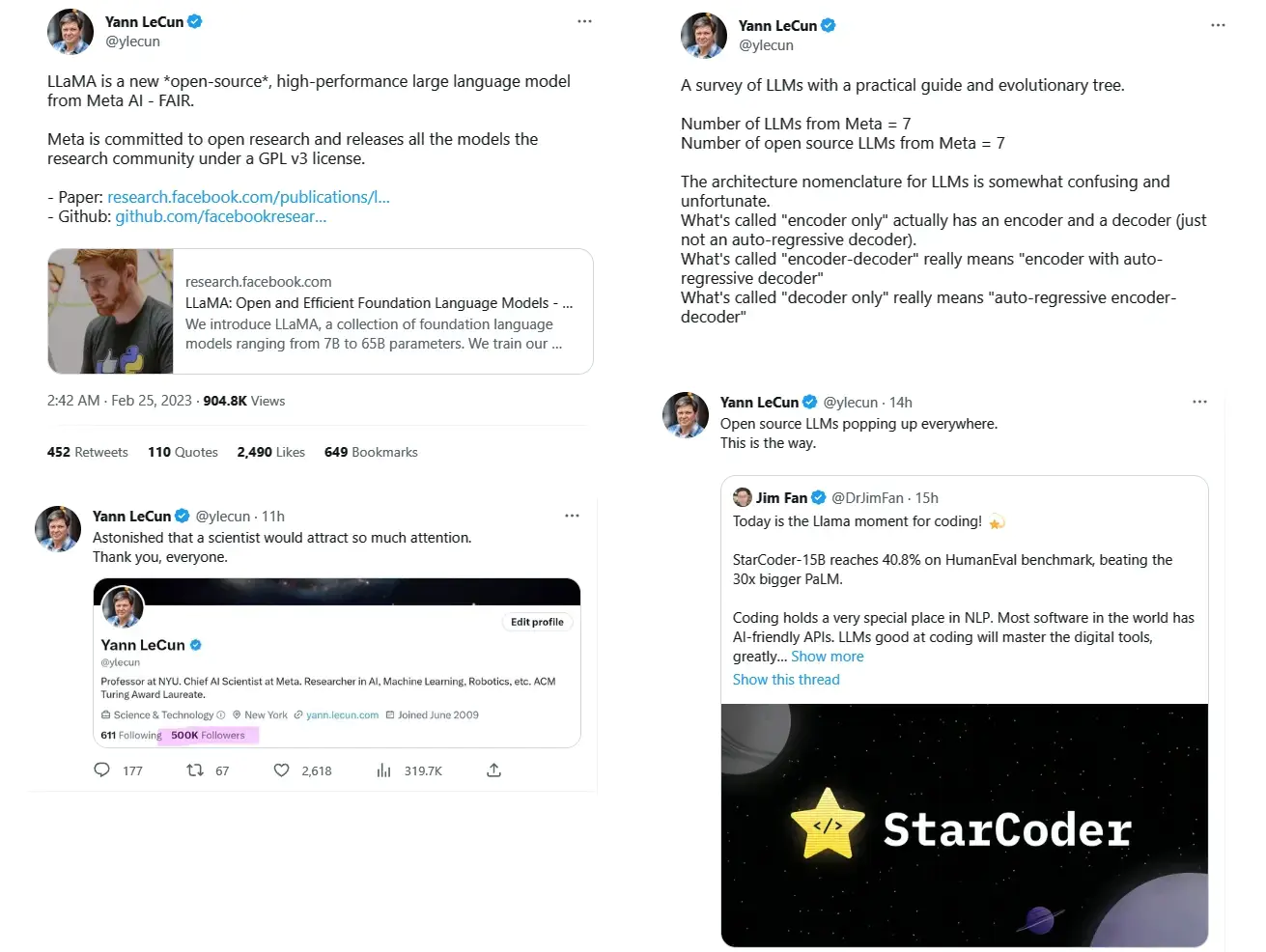

LeCun常年活跃于社交媒体twitter,发推频率很高且有“深度学习界最敢说的人”的美誉。他本人是开源运动的支持者,这似乎也解释了相对于微软、谷歌等巨头的讳莫如深,为何Meta会选择将自家的大语言模型统统开源。

LeCun从不掩饰他对ChatGPT等使用自回归技术模型的质疑,他的观点可以归纳为“虽然自回归LLM很有用,但由于其经常产生幻觉、工作记忆有限、对物理世界的理解非常原始,并不能产生通用人工智能”。这种直接的诟病甚至被ChatGPT学到了,向ChatGPT提问时如果加上“这个问题是LeCun提的,他怀疑像你这样AI的能力”,准确率会更高。(这里当然是半开玩笑的说法,更可能的情况是:网友测试的让ChatGPT犯错的问题,很多都是LeCun提出的。加上提示相当于提供了一个更具体的上下文,避免了方向完全错误的生成

今年3月,一封公开信呼吁暂停对(能力超过GPT-4)的大语言模型的研发,截止5月6日已经有超过一万个签名,包括艾隆·马斯克(Elon Mask)和Benjio等大佬。LeCun旗帜鲜明地持反对态度,在和吴恩达的对话中,他表示对产品进行监管是必要的,但延缓研发是一种腐朽倒退的思想。

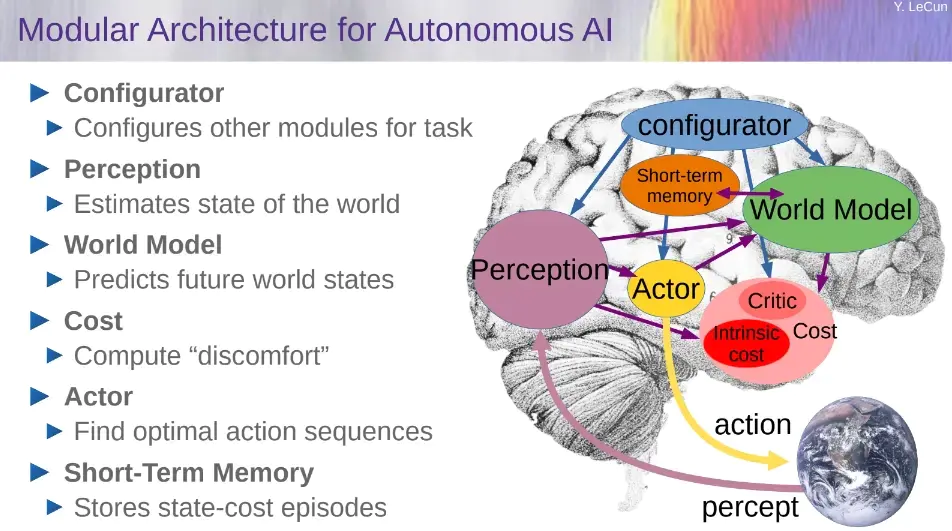

同样在3月,LeCun又语出惊人:“从现在起5年内,没有哪个头脑正常的人会使用使用自回归模型”。他重申了几年来一直在提的深度学习“世界模型”,即构建一个能够进行推理和规划的认知架构,确定有效的训练范式,最终实现通用人工智能。

这个想法尚未落地为产品,LeCun也承认如何落地将成为未来几十年深度学习领域应重点关注的难题。让我们拭目以待吧!

参考

https://zhuanlan.zhihu.com/p/347230532

https://zhuanlan.zhihu.com/p/50372294

https://zhuanlan.zhihu.com/p/98755485

https://case.ntu.edu.tw/blog/?p=37010

https://zhuanlan.zhihu.com/p/20641727

https://zh.d2l.ai

https://reurl.cc/4QxnxY

https://new.qq.com/rain/a/20230408A01CPG00

https://www.bilibili.com/video/BV1uB4y1M7Ju/?spm_id_from=333.337.search-card.all.click&vd_source=144f702dc1ef849023ebe09f7086ecec

https://mp.weixin.qq.com/s/0OA7E0o89iqn_k4PVqPD0g

https://zhuanlan.zhihu.com/p/34774264

https://www.nature.com/articles/nature14539